중국 AI 기술 발전이 기하급수적인 성장을 보이는 가운데, 화웨이의 AI 컴퓨팅 플랫폼 ‘Ascend CANN’이 개방형 생태계 구축과 핵심 기술 혁신을 통해 중국 AI 산업의 자주적 혁신 기반으로 자리매김하고 있다.

최근 열린 쿤펑 Ascend 개발자 대회에서 화웨이는 Ascend CANN의 주요 기술 업그레이드와 개방형 생태계 전략을 공개하며, 중국 AI 산업의 자주적 발전을 위한 강력한 기반을 제시했다.

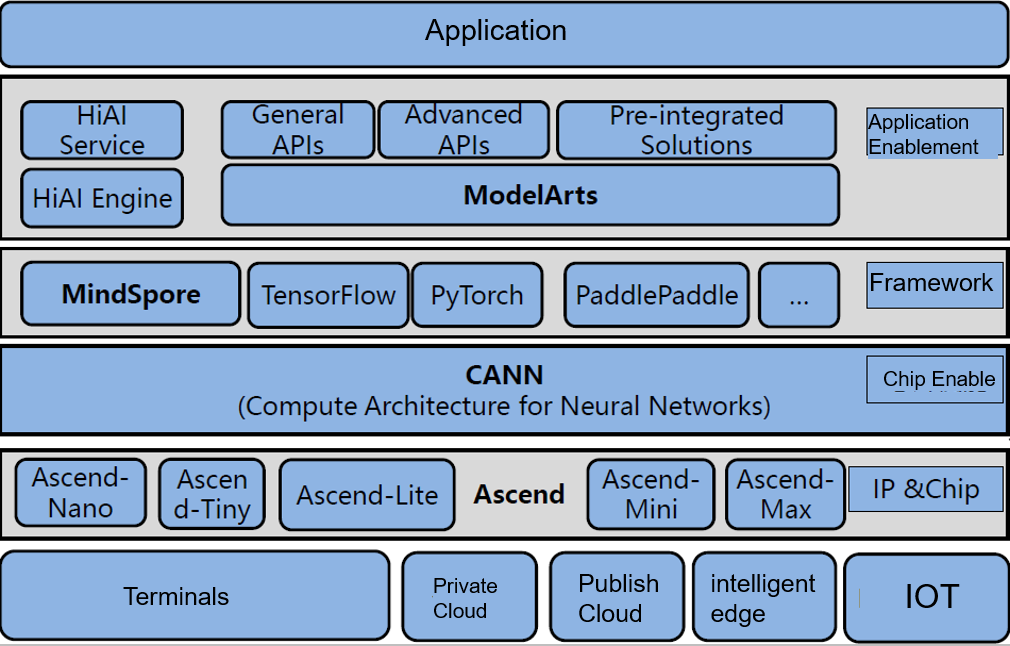

Ascend CANN(Compute Architecture for Neural Networks)

화웨이가 자사의 Ascend AI 프로세서 시리즈를 위해 개발한 이기종 컴퓨팅 아키텍처이자 소프트웨어 플랫폼으로, 이는 NVIDIA의 CUDA와 유사한 역할을 하며, AI 모델의 훈련과 추론을 효율적으로 수행할 수 있도록 지원한다.

AI 혁신 패러다임 변화와 개방형 생태계의 중요성

현재 AI 기술 발전은 단순히 모델 규모 확장이나 하드웨어 성능 향상을 추구하는 단계를 넘어, 저수준 알고리즘 혁신과 하드웨어-소프트웨어 협력을 통한 효율성 극대화에 중점을 두고 있다. 이러한 변화 속에서 AI 개방형 생태계의 완성도가 산업 발전의 핵심 요소로 부상하고 있다.

화웨이 Ascend 컴퓨팅 사업 총재 장디쉬안(張迪煊)은 “모든 혁신가를 지원하고 혁신 잠재력을 발휘하게 하는 것이 Ascend CANN의 핵심 이념”이라고 밝혔다.

Ascend CANN의 개방 전략은 산업 변화와 함께 성장해왔다. 2024년 5월 개발자 대상 대규모 모델 혁신 지원을 위한 심층 개방 전략을 발표한 이후, 7월에는 핵심 고수준 컴포넌트의 소스코드를 Gitee 커뮤니티에 공개하여 고객과 파트너들의 자주적 혁신을 지원하고 있다.

Ascend CANN 계층형 개방 구조와 핵심 기술 혁신

Ascend CANN은 계층형 개방 모델을 통해 다양한 기술 수준의 개발자들에게 차별화된 개방 전략을 제공한다. 알고리즘 혁신 계층에서는 비즈니스 시나리오 기반의 맞춤형 혁신을 지원하고, 시스템 최적화 계층에서는 190여 개의 저수준 인터페이스를 개방하여 하드웨어의 원자 수준 기능을 활용할 수 있도록 한다.

특히 컴파일 생태계 계층에서는 비승(毕昇) 컴파일러의 AscendNPU IR 인터페이스를 개방하여, 개발자들이 Triton 접속 후 Python 문법으로 고성능 연산자를 직접 작성할 수 있게 함으로써 개발 패러다임의 변혁을 이끌고 있다.

3대 핵심 기술 분야의 혁신적 돌파

Ascend CANN은 컴퓨팅, 메모리, 통신의 3대 핵심 영역에서 혁신적 기술 돌파를 실현했다.

컴퓨팅 분야에서는 MoE 대규모 모델 훈련 시나리오의 병목 문제 해결을 위해 슈퍼 연산자 MLAPO를 출시했다. 이를 통해 MLA 전처리 시간을 업계 평균 109ms에서 45ms로 단축시켰으며, 금융 리스크 관리 모델과 광고 추천 시스템에서 20% 이상의 엔드투엔드 성능 향상을 달성했다.

메모리 분야에서는 동적 형태 시나리오의 ‘메모리 단편화’ 문제 해결을 위해 다중 주소 매핑 기술을 개발했다. 이 기술은 메모리 단편의 자동화 연결 활용을 실현하여 징동(京東) 상품 검색, 텐센트 숏비디오 추천 등 비즈니스 시나리오에서 20% 이상의 메모리 활용률 향상을 달성했다.

분산 훈련 분야에서는 NPUDirect 통신 알고리즘을 개발하여 기존 RDMA 통신에 필요한 3쌍의 동기화를 1회의 원자 작업으로 간소화했다. 이를 통해 과다쉰페이(科大讯飞) 음성 대규모 모델의 노드 간 통신 지연을 90% 단축시켜 만장(萬張) 급 분산 훈련의 실현 가능성을 입증했다.

산학협력과 생태계 확장

Ascend CANN의 개방형 생태계에는 30여 개의 산학 파트너가 참여하여 다양한 혁신 성과를 창출하고 있다. iFlytek의 대규모 음성 모델 X1은 Ascend C 기반의 극한 소프트웨어-하드웨어 협력 최적화를 통해 상당한 성능 향상을 달성했다.

과다쉰페이 부총재 겸 AI 공정원 원장 판칭화(潘青华)는 “iFlytek과 Ascend의 인연은 2019년으로 거슬러 올라가며, 대담하게 사용하기, 실제로 사용하기, 잘 사용하기, 잘 활용하기의 4단계를 거쳐 왔다”고 설명했다. 올해 3월에는 Ascend 컴퓨팅 성능을 기반으로 MoE 모델 대규모 노드 간 병렬 클러스터 추론을 세계 최초로 실현하여 전체 추론 성능을 3배 향상시켰다.

AI 인프라 스타트업 우원신궁(无问芯穹)도 Ascend과 협력하여 CANN 기반 심층 최적화 혁신을 통해 대규모 모델 추론 클러스터 배치의 통신 오버헤드 문제를 해결하고 단일 연산자 성능을 20% 향상시켰다.

대학 연구 성과와 인재 양성

칭화대학교 지투(计图) 팀은 Ascend과 공동으로 개발한 MoE 전용 연산자 시스템을 통해 aclGraph 모델 스케줄링 인터페이스와 INT4 양자화 기술을 활용하여 DeepSeek-R1 모델의 추론 지연을 50% 단축시켰다.

시베이공업대학교 소프트웨어학원 부교수 쉬타오(徐韬) 팀은 CANN 플랫폼 기반 수직 모델 구축을 통해 다중 모달 인식 기술로 우울증 환자 초기 진단 시스템을 개발하여 시안교통대학교 제1부속병원에 배치했다.

화난이공대학교 컴퓨터과학공학학원 교수 루루(陆璐)는 “기능이 충분히 강력하고 생태계가 우수하며 동시에 자주적으로 제어 가능한 것이 가장 중요한 세 가지 요소”라고 평가하며, Ascend 플랫폼에서 성능을 50%에서 100%까지, 특정 응용 시나리오에서는 200%에서 500%까지 향상시킬 수 있다고 밝혔다.

개발자 생태계 성장과 미래 전망

6년간 60만 명 이상의 개발자가 CANN을 이해하고 사용하며 혁신 활력을 부여했으며, 현재 CANN의 연산자 인증 개발자는 6000명을 넘어섰다. Ascend는 30여 개 고객 파트너와 협력하여 260여 개의 고성능 연산자를 혁신적으로 개발했으며, 주요 AI 시나리오를 모두 커버하면서 평균 전체 네트워크 성능을 10% 이상 향상시켰다.

통신 분야에서는 Ascend CANN 커뮤니티에 15개 이상의 HCCL 통신 알고리즘 및 API가 공개되었으며, 10여 개 고객 파트너와 협력하여 평균 50% 이상의 통신 효율 향상을 실현했다.

Ascend CANN은 ‘중국판 CUDA’로 비유되지만, 실제로는 6년 만에 CUDA가 십여 년간 걸어온 길을 완주했다는 평가를 받고 있다. 더욱 중요한 것은 후발주자이자 도전자인 Ascend이 CUDA와 달리 기술 장벽을 구축하지 않고 지속적인 개방을 통해 개발자들에게 더욱 자유로운 플랫폼을 제공하고 있다는 점이다.

현재 Ascend CANN은 ‘기초층 개방 + 응용층 공동창조’의 이중 추진 모델을 통해 국산 AI 산업 체인의 협력적 진화를 추진하고 있으며, 기술 돌파에서 상업적 전환까지의 생태계 순환을 형성하고 있다.

AI 기술의 저수준 혁신 돌파구에서 개방형 생태계와 기술 혁신의 결합은 필수적인 선택이다. Ascend CANN은 한 손으로는 개방을, 다른 한 손으로는 기술을 잡고 산업에 AI 혁신의 새로운 패러다임을 제공하고 있다. 중국 AI 산업 발전이 추격에서 선도로 나아가는 과정에서 Ascend CANN은 핵심적인 역할을 담당하고 있으며, 이는 중국 AI 기술의 자주적 혁신 능력을 보여주는 중요한 사례로 평가받고 있다.

[Asscend 홈페이지]

https://www.hiascend.com/en/

[Asscend CANN 관련 자료]

https://support.huawei.com/enterprise/en/ascend-computing/cann-pid-251168373