중국 AI 스타트업 MiniMax가 전세계 최초로 대규모 혼합 아키텍처를 채택한 오픈소스 추론모델 ‘MiniMax-M1’을 공개했다. 4560억 개의 매개변수와 100만 토큰의 컨텍스트 처리 능력을 갖춘 이 모델은 API 가격을 백만 토큰당 0.8위안(약 150원)까지 낮춰 업계에 큰 파장을 일으키고 있다.

4560억 매개변수 규모의 혁신적 추론 모델 등장

6월 17일 새벽, 중국 ‘AI 6대 강자’ 중 하나로 불리는 MiniMax가 M1 모델을 깜짝 발표했다. 이는 전세계 최초의 오픈소스 대규모 혼합 아키텍처 추론 모델로, 총 4560억 개의 매개변수를 보유하고 있으며 토큰당 459억 개의 매개변수가 활성화된다.

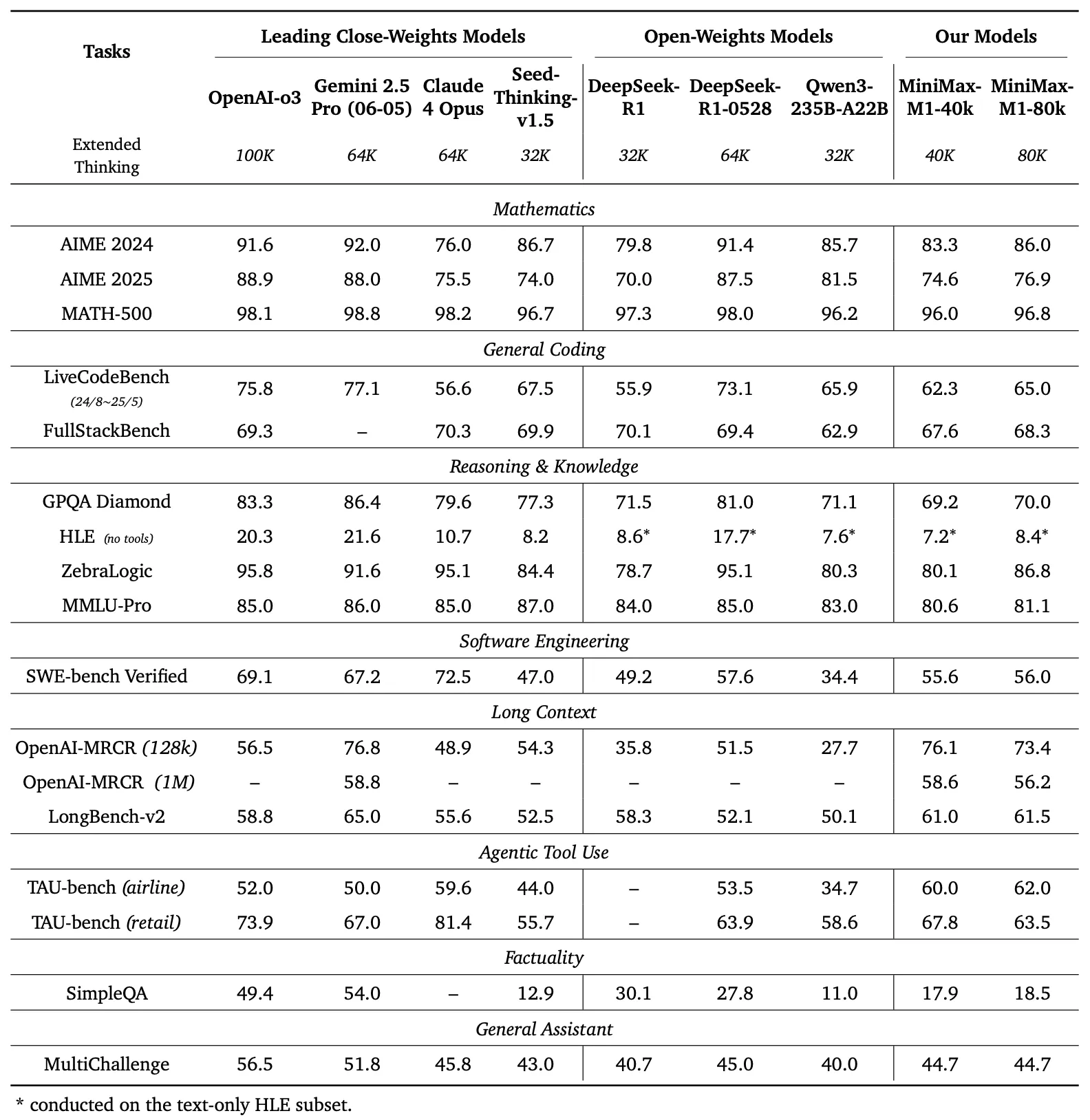

특히 주목할 점은 이 모델이 네이티브로 100만 개의 컨텍스트 입력과 업계 최장 수준인 8만 토큰의 추론 출력을 지원한다는 것이다. 입력 길이는 구글의 폐쇄형 모델인 Gemini 2.5 Pro와 동일하며, DeepSeek-R1보다 8배 긴 처리 능력을 자랑한다.

연구팀은 두 가지 버전의 M1 모델을 훈련 시켰는데, 각각 4만 토큰과 8만 토큰의 사고 예산(thinking budget)을 가지고 있다. 이는 모델이 추론 과정에서 얼마나 많은 계산 자원을 사용할 수 있는 지를 나타내는 지표다.

DeepSeek-R1 대비 우수한 성능과 경쟁력 있는 가격

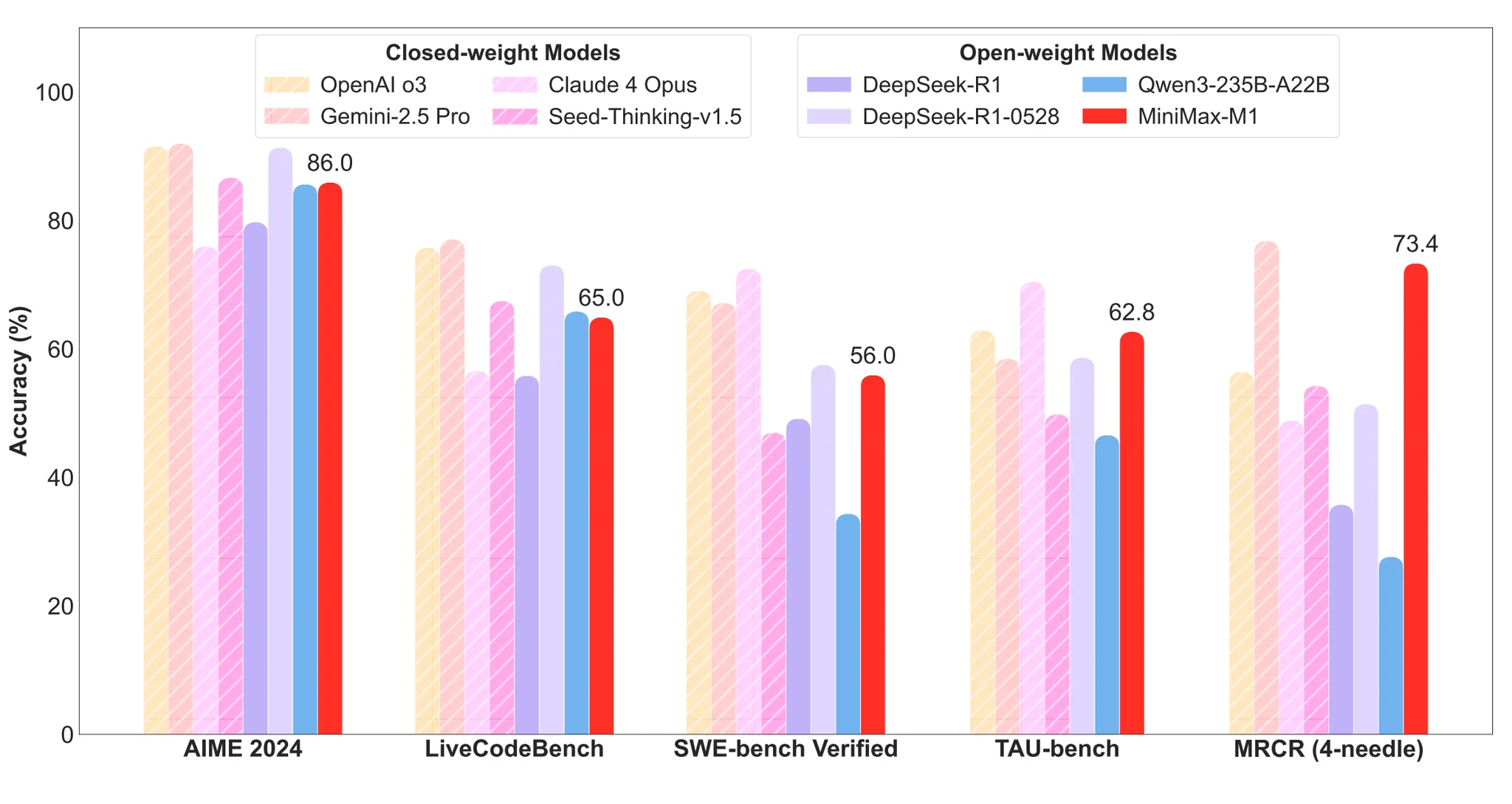

표준 벤치마크 테스트에서 MiniMax-M1은 복잡한 소프트웨어 엔지니어링, 도구 사용, 긴 컨텍스트 작업 분야에서 DeepSeek-R1과 Qwen3-235B 등 기존 오픈소스 모델들을 능가하는 성능을 보였다.

모델 개발 비용 측면에서도 눈에 띄는 성과를 거뒀다. MiniMax는 M1의 전체 강화학습 단계에서 512개의 H800 GPU를 3주간 사용했으며, 임대 비용은 53만 7400달러(약 7억 7000만원)에 불과했다고 밝혔다. 이는 초기 예상 비용보다 한 자릿수 적은 수준이라고 회사 측은 설명했다.

가격 경쟁력도 상당하다. MiniMax-M1은 앱과 웹에서 무제한 무료 사용을 지원하며, API 가격은 세 단계로 구성됐다. 첫 번째 단계인 0-32k 입력 길이에서는 입력이 백만 토큰 당 0.8위안, 출력이 8위안이다. 두 번째 단계인 32k-128k 입력 길이에서는 입력이 1.2위안, 출력이 16위안이다. 세 번째 단계인 128k-1M 입력 길이에서는 입력이 2.4위안, 출력이 24위안으로 책정됐다.

DeepSeek-R1과의 가격 비교에서 MiniMax-M1은 특정 구간에서 가격 우위를 보인다. 표준 시간대 기준으로 첫 번째 단계에서는 입력 가격이 DeepSeek-R1의 80%, 출력 가격이 50% 수준이다. 특히 세 번째 단계는 MiniMax-M1만의 절대적 우위 영역으로, DeepSeek-R1이 128k-1M 입력 길이를 지원하지 않는다.

에이전트 도구 사용 능력에서 독보적 성능

업계 주요 17개 평가 데이터셋을 기반으로 한 테스트에서 MiniMax-M1은 소프트웨어 엔지니어링, 긴 컨텍스트, 도구 사용 등 분야에서 다른 오픈소스 및 폐쇄형 모델보다 우수한 성능을 보였다.

OpenAI가 발표한 MRCR 테스트에서 M1은 Gemini 2.5 Pro에는 약간 뒤졌지만 다른 모델들보다는 뛰어난 효과를 나타냈다. MRCR은 대언어모델이 긴 컨텍스트에 숨겨진 여러 목표를 구분하는 능력을 평가하는 테스트로, 극도로 복잡하고 다중 간섭이 있는 긴 텍스트에서 거의 동일한 여러 정보를 정확히 구분하고 순서까지 식별해야 하는 고난도 작업이다.

소프트웨어 엔지니어링 능력을 평가하는 SWE-bench Verified 테스트에서 MiniMax-M1-40k와 80k는 DeepSeek-R1-0528보다는 약간 뒤졌지만 다른 오픈소스 모델들보다는 우수한 성과를 보였다.

특히 에이전트 도구 사용 분야에서는 독보적인 성능을 발휘했다. 항공업 테스트 데이터셋인 TAU-bench(airline)에서 MiniMax-M1-40k는 다른 모든 오픈소스 및 폐쇄형 모델을 능가했으며, 소매업 테스트 데이터셋인 TAU-bench(retail)에서는 DeepSeek-R1과 비슷한 수준의 성능을 보였다.

하지만 수학과 프로그래밍 능력 분야에서는 Qwen3-235B-A22B, DeepSeek-R1, Claude 4 Opus 등에 비해 상대적으로 낮은 점수를 기록했다. 이는 모델의 특성화된 강점과 개선 여지를 동시에 보여주는 결과다.

흥미롭게도 MiniMax-M1-80k는 대부분의 벤치마크 테스트에서 MiniMax-M1-40k보다 일관되게 우수한 성능을 보였다. 이는 테스트 시 계산 자원 확장의 효과성을 입증하는 결과로 해석된다.

라이트닝 어텐션 메커니즘과 혁신적 강화학습 기술

MiniMax-M1은 MiniMax-Text-01 모델을 기반으로 개발됐으며, 혼합 전문가(MoE) 아키텍처와 라이트닝 어텐션 메커니즘을 채택했다. 이 라이트닝 어텐션 메커니즘은 테스트 시 계산을 고효율로 확장할 수 있는 핵심 기술이다.

예를 들어, DeepSeek-R1과 비교했을 때 M1은 10만 개 토큰 생성 길이에서 단 25%의 FLOP만 소모한다. 이러한 효율성 덕분에 M1은 긴 입력과 광범위한 사고가 필요한 복잡한 작업에 특히 적합하다.

또 다른 기술적 핵심은 대규모 강화학습(RL)을 사용한 훈련이다. 이 접근법은 전통적인 수학 추론부터 샌드박스 기반의 실제 소프트웨어 엔지니어링 환경까지 광범위한 문제를 다룰 수 있다.

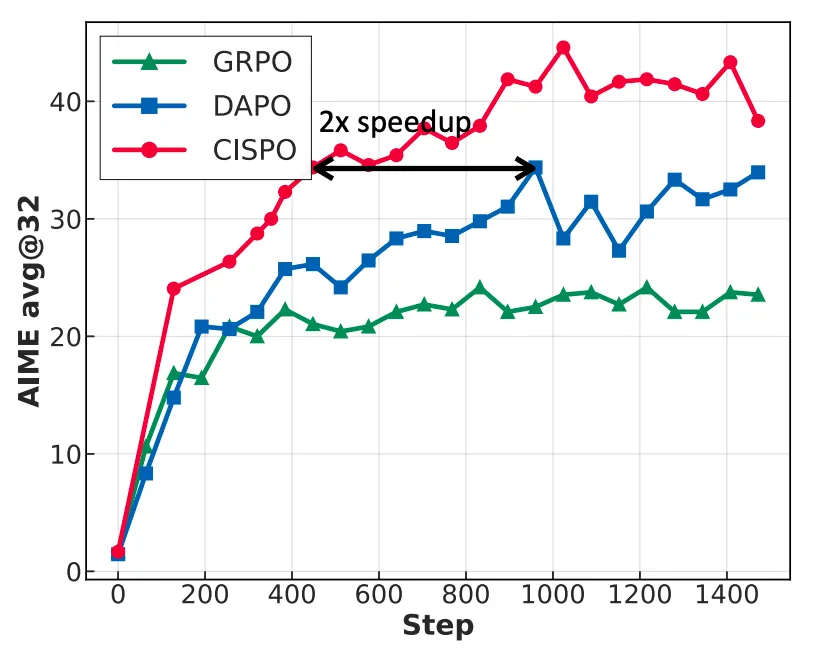

MiniMax는 M1을 위해 RL 확장 프레임워크를 개발했는데, 여기에는 몇 가지 중요한 혁신이 포함됐다. 우선 CISPO라는 새로운 알고리즘을 제안했다. 이 알고리즘은 토큰 업데이트 대신 중요도 샘플링 가중치를 조정하여 성능을 향상시키며, 다른 경쟁 RL 변형들보다 우수한 성능을 보인다.

또한 혼합 어텐션 메커니즘 설계를 통해 RL 효율성을 높이고, 혼합 아키텍처를 활용해 RL 확장 시 직면하는 과제들에 대응했다. AIME 실험에서 CISPO는 바이트댄스가 최근 제안한 DAPO 등 강화학습 알고리즘보다 수렴 성능이 2배 빨랐으며, DeepSeek이 초기에 사용한 GRPO보다 현저히 우수한 성과를 보였다.

연구팀은 Qwen2.5-32B-base 모델을 기반으로 한 AIME 2024 작업에서 GRPO, DAPO, CISPO를 비교했다. 결과적으로 동일한 훈련 단계에서 CISPO의 성능이 GRPO와 DAPO보다 우수했으며, 50%의 훈련 단계만 사용해도 DAPO와 비슷한 성능을 달성할 수 있었다.

다중 에이전트 협업의 미래를 향한 기술적 도전

점점 복잡해지는 시나리오를 지원하기 위해 대언어모델은 테스트나 추론 단계에서 동적으로 계산 자원이나 계산 단계를 증가시켜 모델 성능을 향상시켜야 한다. MiniMax는 연구 보고서에서 미래의 대모델이 특히 ‘언어 풍부 중재자(Language-Rich Mediator)’가 필요하다고 언급했다.

이는 환경, 도구, 컴퓨터 또는 다른 에이전트와 상호작용하는 에이전트 역할을 하는 것으로, 수십에서 수백 라운드의 추론을 진행하면서 동시에 다양한 소스로부터의 긴 컨텍스트 정보를 통합해야 한다.

이러한 배경에서 첫 번째 추론모델인 M1은 이런 업계 발전 트렌드에 대응하는 알고리즘 혁신 탐구의 결과물이라고 할 수 있다. 특히 100만 토큰의 컨텍스트 처리 능력과 8만 토큰의 출력 능력은 미래의 다중 에이전트 협업 시나리오에서 핵심적인 역할을 할 것으로 예상된다.

흥미롭게도 MiniMax와 거의 동시에 중국 ‘AI 6대 강자’의 또 다른 회사인 Moonshot AI도 오픈소스 코드 모델 Kimi-Dev를 발표했다. 이 모델은 프로그래밍 능력에서 DeepSeek-R1을 넘어서는 성능을 보인다고 알려져 있어, 중국 AI 업계의 치열한 경쟁이 가속화되고 있음을 보여준다.

MiniMax-M1의 등장은 오픈소스 AI 모델 생태계에 중요한 변화를 가져올 것으로 예상된다. 특히 긴 컨텍스트 처리와 복잡한 추론이 필요한 응용 분야에서 새로운 가능성을 열어줄 것으로 보인다. 동시에 경쟁력 있는 가격 정책은 AI 서비스의 대중화에도 기여할 것으로 전망된다.

[서비스 웹페이지]

https://chat.minimax.io/