중국 알리바바의 Qwen팀과 칭화대학교 LeapLab이 공동으로 대형언어모델(LLM) 강화학습 분야에서 기존 상식을 뒤바꾸는 연구 결과를 발표했다. 이들은 강화학습 훈련 시 전체 토큰의 20%에 해당하는 핵심 토큰만을 사용해도 전체 토큰을 활용한 훈련보다 더 나은 성능을 달성할 수 있다는 혁신적인 발견을 공개했다.

20% 핵심 토큰으로 더 나은 성능 달성

이번 연구에서 가장 주목할 만한 성과는 Qwen3-32B 모델에서 달성한 새로운 최고 기록이다. AIME’24에서 63.5점, AIME’25에서 56.7점을 기록하며, 600B 파라미터 이하 베이스 모델에서 직접 훈련한 모델 중 최고 성능을 보였다. 더욱 놀라운 것은 최대 응답 길이를 20k에서 29k로 확장했을 때 AIME’24 점수가 68.1점까지 상승했다는 점이다.

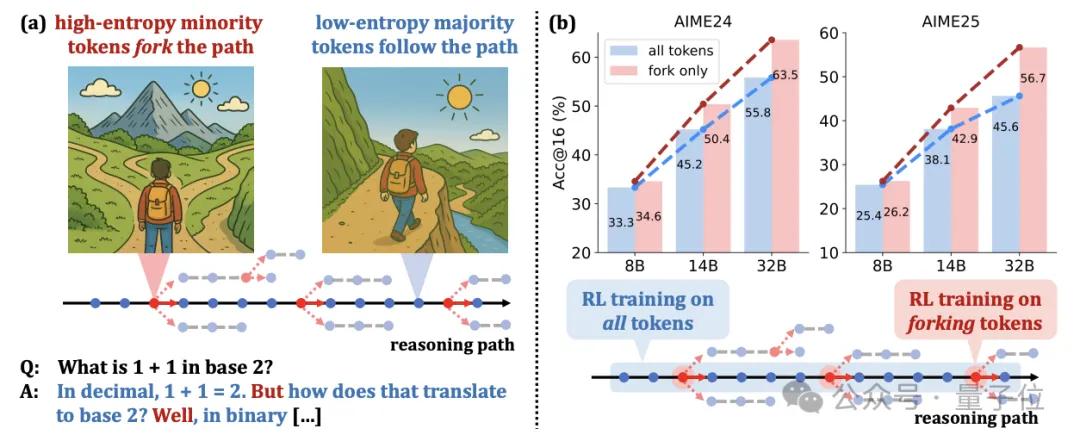

연구팀이 발견한 핵심은 ‘고엔트로피 토큰(high-entropy token)’의 중요성이다. 전체 토큰 중 단 20%에 해당하는 이러한 고엔트로피 토큰들이 모델의 추론 능력 향상에 결정적인 역할을 한다는 것이다. 반대로 나머지 80%의 저엔트로피 토큰들은 오히려 부정적인 영향을 미칠 수 있어 ‘파레토 법칙을 뛰어넘는’ 현상이라고 명명했다.

체인 오브 소트(Chain-of-Thought)의 엔트로피 분포 해석

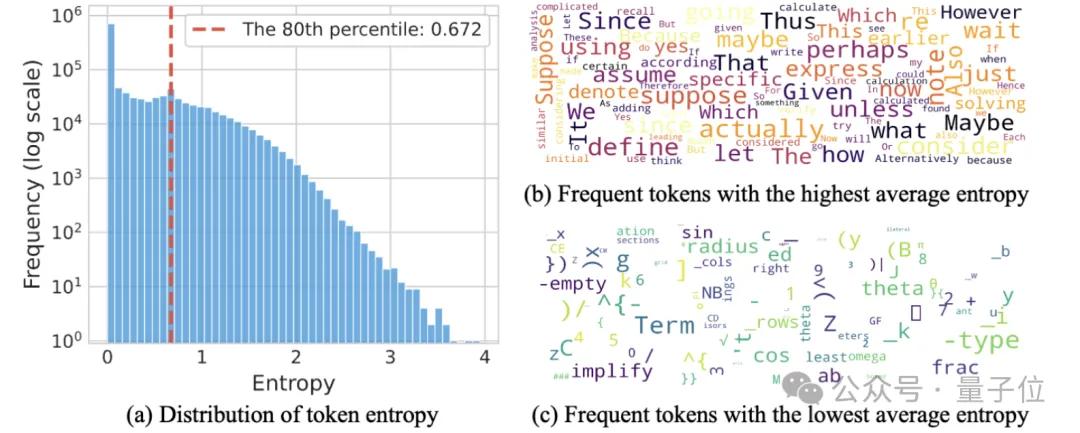

연구팀은 대형언어모델이 체인 오브 소트 추론을 수행할 때 토큰의 엔트로피 분포가 독특한 패턴을 보인다는 점을 발견했다. 전체 토큰의 50% 이상이 0.01 미만의 낮은 엔트로피 값을 가지는 반면, 단 20%의 토큰만이 0.672 이상의 높은 엔트로피를 보였다.

이러한 고엔트로피 토큰들은 ‘논리적 연결자’ 역할을 수행한다. 예를 들어 ‘wait’, ‘however’, ‘thus’ 같은 단어들이 추론 과정에서 전환점, 발전, 인과관계 연결 기능을 담당한다. 수학적 추론에서는 ‘suppose’, ‘assume’, ‘given’ 등 가정이나 조건을 도입하는 단어들도 고엔트로피 토큰에 해당한다.

연구팀은 이러한 고엔트로피 토큰을 ‘분기 토큰(forking tokens)’이라고 명명했다. 사고 체인을 산길 걷기에 비유하면, 고엔트로피 토큰은 갈래길 같은 분기점으로서 다음 방향을 결정하는 역할을 하고, 저엔트로피 토큰은 한쪽은 산, 다른 쪽은 절벽인 좁은 길처럼 기정된 방향으로만 진행할 수 있는 확정적인 경로를 의미한다.

실험 검증과 성능 개선 효과

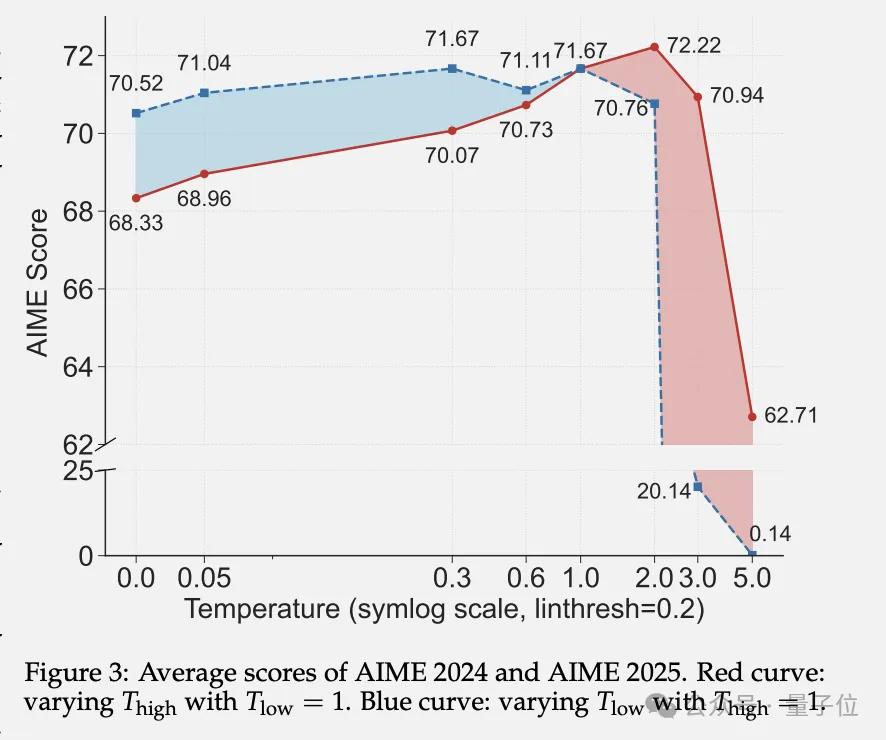

분기 토큰의 중요성을 검증하기 위해 연구팀은 서로 다른 토큰에 다른 디코딩 온도를 설정하는 실험을 실시했다. 그 결과 고엔트로피 토큰의 온도를 적절히 높이면 추론 성능이 개선되는 반면, 온도를 낮추면 성능이 저하됨을 확인했다. 이는 이러한 핵심 위치에서 높은 엔트로피를 유지하는 것이 추론에 얼마나 중요한지를 보여준다.

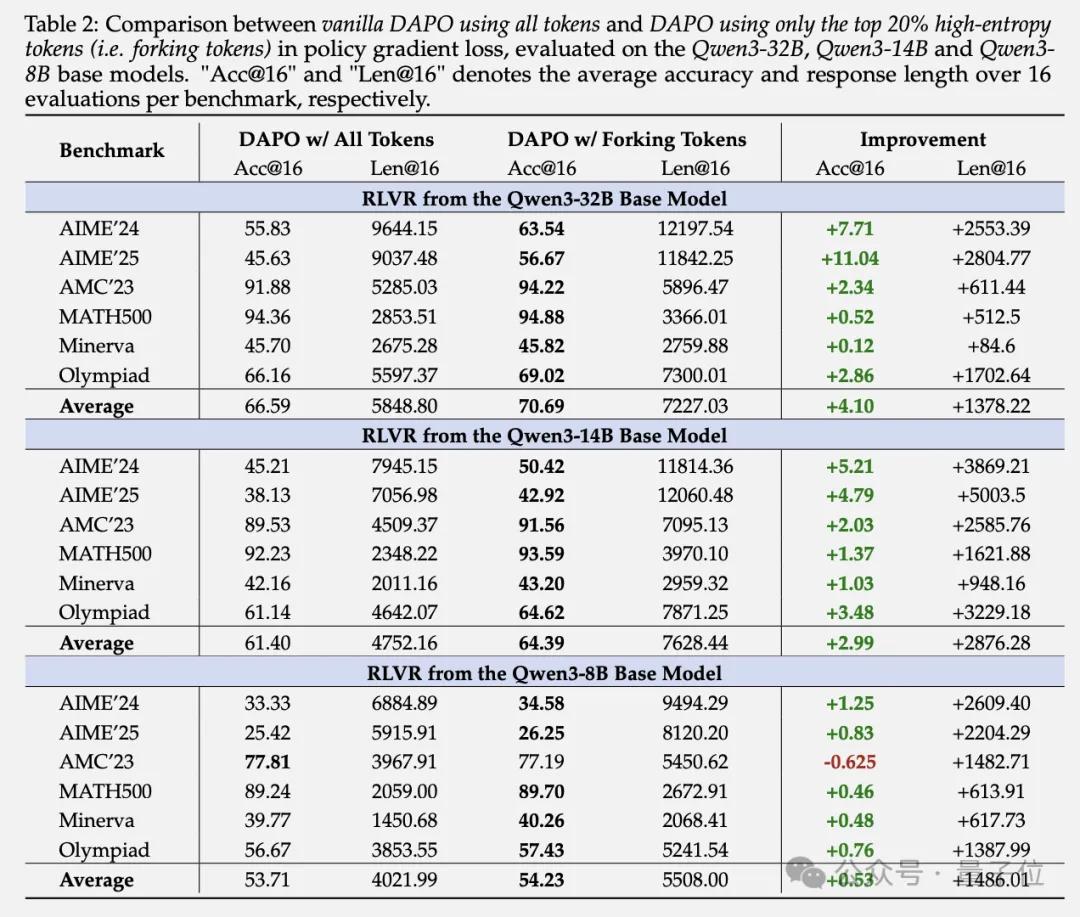

RLVR(Reinforcement Learning with Verifiable Rewards) 훈련에서 상위 20% 고엔트로피 토큰의 정책 기울기만 유지하고 나머지 80%의 기울기를 모두 차단하는 방법을 적용한 결과, Qwen3-32B에서 놀라운 성능 향상을 달성했다. AIME’24에서 7.71점, AIME’25에서 11.04점이 향상되었으며, 평균 응답 길이도 약 1,378개 토큰 증가했다.

Qwen3-14B에서도 유사한 개선 효과를 보였고, 상대적으로 작은 Qwen3-8B에서도 안정적인 성능을 유지했다. 흥미롭게도 역방향 실험에서 80%의 저엔트로피 토큰만으로 훈련했을 때는 모델 성능이 급격히 저하되어, 저엔트로피 토큰이 추론 능력 향상에 거의 기여하지 않거나 오히려 부정적 영향을 미칠 수 있음을 입증했다.

규모 효과와 일반화 능력

이 방법론에는 명확한 규모 효과가 존재한다. 모델이 클수록 고엔트로피 토큰만을 사용한 훈련의 장점이 더욱 두드러진다. 32B 모델에서 가장 큰 개선을 보였고, 14B가 그 다음, 8B 모델에서는 개선 폭이 가장 작았다. 이는 더 큰 모델일수록 향상된 탐색성을 활용할 수 있는 능력이 뛰어나기 때문인 것으로 분석된다.

더욱 인상적인 것은 이 방법으로 훈련된 모델이 도메인 외 작업에서도 우수한 성능을 보인다는 점이다. 수학 데이터셋으로 훈련한 모델을 프로그래밍 작업인 LiveCodeBench에서 테스트했을 때, 20% 고엔트로피 토큰만 사용해 훈련한 모델이 전체 토큰으로 훈련한 버전을 크게 앞질렀다.

이는 고엔트로피 토큰이 모델의 일반화 능력과 밀접한 관련이 있음을 시사한다. 이러한 핵심 결정점에 집중함으로써 모델이 특정 도메인 지식을 단순 암기하는 것이 아니라 더 본질적인 추론 패턴을 학습하는 것으로 보인다.

강화학습 메커니즘의 새로운 이해

이번 연구는 단순한 훈련 효율성 개선을 넛어 대형언어모델 강화학습에 대한 새로운 통찰을 제공한다. RLVR 훈련 과정을 심층 분석한 결과, RLVR은 완전히 새로 시작하는 것이 아니라 베이스 모델을 기반으로 정밀한 조정을 수행한다는 사실을 발견했다.

훈련 과정에서 엔트로피 패턴의 변화를 추적한 결과, 훈련이 수렴한 후(1360단계)에도 모델과 베이스 모델 간 고엔트로피 토큰 위치의 중복률이 86.67% 이상 유지되었다. 이는 RLVR이 사전 훈련된 모델의 ‘어디서 망설이고 어디서 확신해야 하는지’에 대한 판단을 기본적으로 보존한다는 의미다.

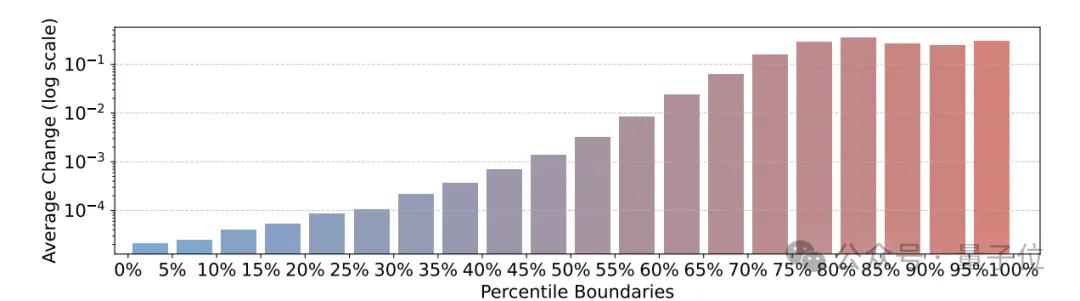

더 흥미로운 점은 RLVR의 조정 전략이 상당히 ‘편향적’이라는 것이다. 연구팀이 서로 다른 엔트로피 수준의 토큰들이 훈련 전후에 어떻게 변화하는지 계산한 결과, 명확한 규칙을 발견했다. 초기 엔트로피가 높은 토큰일수록 RLVR 훈련 후 엔트로피 증가폭이 더 컸다. 반면 원래 확정적이었던 저엔트로피 토큰들은 전체 훈련 과정에서 거의 변화가 없었다.

강화학습과 지도학습의 본질적 차이

연구팀은 이러한 발견을 바탕으로 몇 가지 중요한 논의점을 제시했다. 첫째, 고엔트로피 토큰이 강화학습이 일반화할 수 있는 반면 지도 미세조정이 암기에 치우쳐 과적합되는 경향을 설명하는 핵심일 가능성이다.

강화학습은 분기 토큰의 엔트로피를 유지하거나 증가시켜 추론 경로의 유연성을 보존하는 경향이 있다. 반면 지도 미세조정은 출력 logit을 원-핫 분포로 밀어붙여 분기 토큰의 엔트로피를 감소시키고 추론 경로의 유연성을 상실시킨다. 이러한 유연성이야말로 추론 모델이 미지의 작업에 효과적으로 일반화할 수 있는 핵심 요소일 것이다.

둘째, 전통적인 강화학습과 달리 대형언어모델 추론은 선험 지식을 통합해야 하며 가독성 있는 출력을 생성해야 한다. 따라서 대형언어모델의 체인 오브 소트에는 저엔트로피의 다수 토큰과 고엔트로피의 소수 토큰이 포함되는 반면, 전통적인 강화학습에서는 전체 과정에서 행동 엔트로피가 균등하게 분포한다고 가정할 수 있다.

셋째, RLVR에서 엔트로피 보너스가 최적의 선택이 아닐 수 있다는 점이다. 엔트로피 보너스는 저엔트로피 다수 토큰의 엔트로피 값을 증가시키기 때문이다. 이에 비해 clip-higher 방법은 고엔트로피 소수 토큰의 엔트로피 값을 효과적으로 향상시킬 수 있다.

이번 연구는 대형언어모델의 강화학습 훈련에서 ‘적은 것이 더 많은 것’이라는 역설적 현상을 입증했다. 핵심 토큰에 집중하는 전략이 단순히 계산 효율성을 높이는 것을 넘어 실제 성능 향상까지 가져올 수 있다는 점에서, 향후 AI 모델 훈련 방법론에 상당한 영향을 미칠 것으로 전망된다.

[논문 링크]

https://arxiv.org/abs/2506.01939

[프로젝트 홈페이지]

https://shenzhi-wang.github.io/high-entropy-minority-tokens-rlvr/